Einreichungen zum npi 2025

Für den Nachhaltigkeitspreis der Fakultät für Informatik der TU Dortmund, der 2025 zum zweiten Mal vergeben wird, haben wir sechs Einreichungen in eine Short List übernommen. Im Zeitraum 22.10.2025 - 05.11.2025 findet für alle Mitglieder der Fakultät ein öffentliches Votum statt, bei dem Feedback und Meinungen zu den Einreichungen abgebeben werden können. Im November dann wird die Jury, in der neben Mitgliedern aller Statusgruppen der Fakultät auch das Nachhaltigkeitsbüro, die Alumni der Informatik und das ICD e.V. vertreten sind, über die Preisvergabe entscheiden.

Die Einreichungen wurden in die beiden Kategorien "Ideen und Projekte in der Umsetzung" und "Fertige Projekte" aufgeteilt. Wir bitten in dieser LimeSurvey-Umfrage um individuelles Feedback bzgl. dieser beiden Bereiche.

Short List

Kategorie: "Fertige Projekte"

Ground-Truthing AI Energy Consumption

Raphael Fischer

Tools like CodeCarbon estimate the energy draw of running AI, however neglect important factors. To shed light on the dark figures of the environmental impact of AI, I developed a validation framework for estimation approaches, measuring the ground-truth energy demand of over 100 AI experiments.

To uncover how modern artificial intelligence (AI) and machine learning (ML) impact our environment, tools like the ML Emissions Calculator [1] and CodeCarbon [2] were developed. They estimate energy consumption and carbon emissions of running AI models, however make pragmatic assumptions and neglect important factors, raising the question of prediction accuracy [3]. In my project, I therefore evaluated static and dynamic estimation approaches through comparisons with ground-truth measurements [4], thus advancing SDG 13 (Climate Change) by ground-truthing AI energy consumption and the resulting environmental impact.

My developed validation framework uses external energy meters and computer vision to assess the practical energy demand of AI across hundreds of experimental configurations. The results are attached to this submission and already available to the public at github.com/raphischer/ai-energy-validation, while the respective research paper is currently under review. My studyevidences that tools like CodeCarbon and the ML Emissions Calculator generally follow the patterns of AI energy consumption, however consistently make errors of up to 40%. Considering the thousands of citations [1] and millions of downloads (PyPI information on CodeCarbon), it can be assumed that these approaches resulted in many underestimations of the environmental impacts of AI, solidifying the importance of my work.

By contributing a validation methodology and empirical analysis of energy estimation accuracy, my project promotes transparency and validates widely used tools for sustainable AI development. It also formulates guidelines for improving the state-of the-art and allows for translating the evaluation to other domains and tools. The practical impact of my work goes beyond AI applications, as the analyzed tools and proposed methodology can also be applied to other software and computer science projects. I firmly believe that my investigation solidifies the spirit of sustainable development in the context of AI, and hope that it is seen as valuable contribution by the jury of the sustainability award (Nachhaltigkeitspreis).

[1] S. Luccioni, V. Schmidt, A. Lacoste, and T. Dandres, “Quantifying the carbon emissions of machine learning,” in NeurIPS Workshop on Tackling Climate Change with Machine Learning, 2019. [Online]. Available: https: //climatechange.ai/papers/neurips2019/22

[2] B. Courty, V. Schmidt, S. Luccioni, Goyal-Kamal, M. Coutarel et al., “mlco2/codecarbon: v2.4.1,” May 2024.

[3] R. Fischer, “Advancing the sustainability of machine learning and artificial intelligence via labeling and meta-learning,” Ph.D. dissertation, TU Dortmund University, 2025.

[4] R. Fischer, “Ground-Truthing AI Energy Consumption: Validating CodeCarbon Against External Measurements,” under review, 2025.

Nachhaltige LLMs: Energieeffizienz und Transparente Kennzeichnung

Alexander van der Staay, Raphael Fischer, Florian Hermann, Sebastian Buschjäger, Grigorii Iakovlev, Christian Janiesch

Unser Forschungsprojekt untersucht den Energieverbrauch von Sprachmodellen und entwickelt nachhaltige Alternativen. Ziel sind Small Language Models, die lokal, energieeffizient und datenschutzfreundlich laufen, sowie ein Kennzeichnungssystem ähnlich EU-Labels für transparente KI-Nutzung.

Große Sprachmodelle (LLMs) haben sich in kürzester Zeit zu einem zentralen Werkzeug in Forschung, Wirtschaft und Gesellschaft entwickelt. Ihr Nutzen ist unbestreitbar – jedoch geht ihr Einsatz mit erheblichem Energieverbrauch und damit einem hohen CO₂-Fußabdruck einher. Unser Projekt adressiert diese Herausforderung und verfolgt das Ziel, eine nachhaltigere Nutzung von KI-Systemen zu ermöglichen. Im ersten Schritt haben wir ein Experiment entwickelt, das den Energieverbrauch verschiedener Modelle in Abhängigkeit von Abfragearten(z. B. mit/ohne Höflichkeit, kurze vs. komplexe Prompts) systematisch misst. Dabei zeigte sich, dass kleine Variationen in der Promptgestaltung große Unterschiede im Energiebedarf verursachen können. Diese Ergebnisse belegen, dass bereits die Gestaltung der Interaktion mit einem Modell erheblichen Einfluss auf dessen Nachhaltigkeit hat. Dieses Experiment ist jedoch nur der Auftakt. Unser langfristiges Ziel ist die Erforschung sogenannter Small Language Models (SLMs), die bei vergleichbarer Leistungsfähigkeit deutlich energieeffizienter arbeiten und zudem lokal auf Endgeräten betrieben werden können – ohne Abhängigkeit von externen Rechenzentren und ohne Risiken für die Daten- und Privatsphäre. Dadurch ergeben sich neue Chancen für eine nachhaltige, demokratisierte und datenschutzkonforme Nutzung von KI.Darüber hinaus möchten wir einen weiteren Schritt gehen: Die Entwicklung eines Kennzeichnungssystems für Sprachmodelle, ähnlich den bekannten Verbraucherlabels in der EU (z. B. Energieeffizienzklassen). Während die Labeling Idee bereits in mehreren Publikationen des Lamarr-Instituts erforscht wurde, beschränkte sie sich doch auf einfache Bildklassifikatoren. Diese Idee soll auf LLMs übertragen werden. Ein Verbraucherlabel Label würde es Nutzer:innen ermöglichen, den ökologischen Fußabdruck von KI-Anwendungen transparent nachzuvollziehen und bewusste Entscheidungen zu treffen. Dieses Vorhaben erfordert interdisziplinäre Forschung und kann langfristig zu einem Standard beitragen, der Nachhaltigkeit im Bereich Künstlicher Intelligenz sichtbar macht.

Unser Projekt verbindet wissenschaftliche Analyse mit gesellschaftlicher Wirkung. Einerseits schaffen wir ein besseres Verständnis der ökologischen Dimension von KI-Nutzung. Andererseits entwickeln wir konkrete Ansätze, um Emissionen zu reduzieren – durch energieeffizientere Modelle und transparente Verbraucherinformation. So leisten wir einen Beitrag zur ökologischen Nachhaltigkeit, aber auch zur sozialen Verantwortung im Umgang mit zukunftsweisender Technologie.

Mit dem Nachhaltigkeitspreis möchten wir die Weiterentwicklung unseres Projekts fördern, insbesondere die Validierung von SLMs als nachhaltige Alternative und die Konzeption eines Pilotlabels für KI-Systeme. Unser Ziel ist es, die Grundlage für eine neue Kultur verantwortungsvoller KI-Nutzung an unserer Fakultät und darüber hinaus zu schaffen.

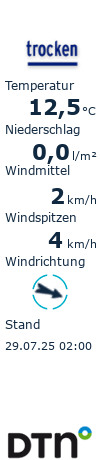

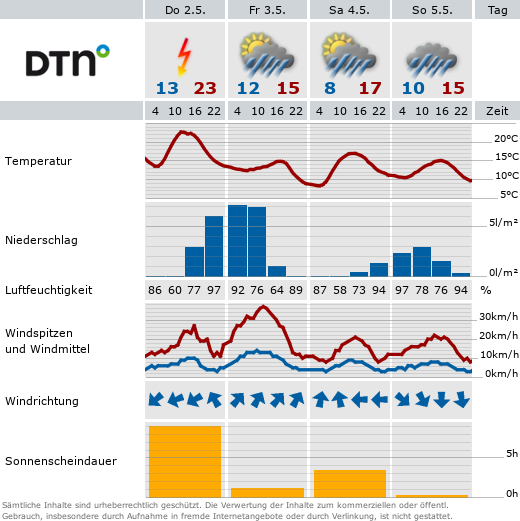

Anbei sind Bilder der bisherigen KI-Labeling Idee.

Interaktive und barrierearme Vorlesungsfolien mit Decker

Mario Botsch, Sebastian Hauer

Decker ist ein Software-Werkzeug zur Erstellung, Präsentation und Konsumption

von barrierearmen, interaktiven Vorlesungsfolien für den Webbrowser.

Unsere Informatik-Studierenden sind eine erfreulich bunte, aber zwangsläufig auch sehr heterogene

Gruppe. Auch wenn die (Hochschul)Politik stets das Ideal der Präsenzuniversität betont, können

viele Studierende oft nicht in Präsenz an Lehrveranstaltungen teilnehmen, zum Beispiel wegen

überfüllter Hörsäle, langer Pendelzeiten, Nebenjobs oder Care-Arbeit. Aufgrund unserer großen

Studierendenzahlen sind rein statistisch auch einige Studierende mit besonderen Bedarfen dabei,

z.B. durch Einschränkungen bei Sehen, Hören oder Motorik.

Unser Ziel ist es, *allen* Studierenden durch bestmögliche Lernmaterialien ein erfolgreiches

Studium zu ermöglichen, auch (oder insbesondere) unter den oben skizzierten herausfordernden

Bedingungen. Aus diesem Grund haben wir das Tool "Decker" entwickelt, mit dem web-basierte

Vorlesungsfolien erstellt, präsentiert und konsumiert werden können. Decker wird seit 2016 an der

BHT Berlin, Uni Würzburg und TU Dortmund entwickelt. Im Projekt "Hybrid Learning Center" lag der

Fokus der Dortmunder Entwicklungen der letzten Jahre auf der Barrierefreiheit der Lernmaterialien.

Decker-Folien laufen im Webbrowser von Desktop-PCs, Laptops, Tablets und Smartphones.

"Tafelanschriften" auf dem virtuellen Whiteboard sowie Vorlesungsvideos, welche auf Knopfdruck

aufgezeichnet werden, sind nahtlos in die HTML-Folien integriert. Auf jeder Folie können anonym

Fragen gepostet und von Lehrenden beantwortet werden. Integrierte Live-Quizzes während der

Präsenzvorlesung dienen in der Nachbereitung zum Überprüfen des Lernstandes. Dank dieser

Features können Lerninhalte im eigenen Tempo zuhause erarbeitet werden. Für

Vorlesungsaufzeichnungen werden automatisch deutsche und englische Untertitel erzeugt, was

Studierenden mit Höreinschränkungen oder Sprachproblemen hilft. Für Erstere stehen auch Live-

Untertitel während der Vorlesung zur Verfügung. Studierende mit visuellen Einschränkungen

profitieren von wählbaren Farbschemata (light, dark, high contrast) und der Kompatibilität der

HTML-Folien mit Screen-Readern, welche Text *und* Mathe-Formeln vorlesen. Studierende mit

motorischen Einschränkungen können Decker-Folien komplett über Tastatur navigieren und

bedienen.

Im Austausch mit dem DoBuS haben wir in den letzten 4 Jahren über 20 Accessibility-Probleme

behoben und so die Barrierefreiheit optimiert. Decker-Folien verbessern Lernbedingungen und

Chancengleichheit für unsere heterogene Studierendenschaft (SDG-10) und ermöglichen damit

mehr Personen eine hochwertige Bildung (SDG-4).

Seit den ersten Decker-Vorlesungen an der TU Dortmund im WS2020 hat jedes Semester eine

Decker-Vorlesung den Lehrpreis der Fakultät erhalten. Mittlerweile sind viele Kolleg*innen auf

Decker umgestiegen, sodass alle Informatik-Vorlesungen der ersten beiden BA-Semester

"verdeckert" sind.

Beispiele einer Präsenz- und einer Inverted-Classroom-Vorlesungen (Zugangsdaten user=graphics,

password=rocks) gibt es unter http://graphics.rocks/cg und http://graphics.rocks/gm

Katerorie: "Ideen und Projekte in der Umsetzung"

GMB-ECC: Systemweites Energie-Benchmarking und Optimierung im Edge-Cloud-Continu

Jahnke, Brian-Frederik, Rebecca Schmook, Falk Howar

GMB-ECC ist ein Framework zur systemweiten Messung, Benchmarking und Optimierungssteuerung der Energieeffizienz im Edge-Cloud-Continuum, das gezielt Nachhaltigkeitspotenziale identifiziert und priorisiert.

Kernaussagen und Innovation:

GMB-ECC ist ein Framework, das erstmals eine systemweite, datenbasierte Steuerung von

Nachhaltigkeit in Edge-Cloud-Umgebungen ermöglicht. Es adressiert die zentrale Herausforderung,

dass bisherige Ansätze meist nur einzelne Komponenten optimieren und dadurch das

Gesamtsystem ineffizient bleibt. GMB-ECC modelliert das gesamte System (z.B. Abb. 1) als

gerichteten azyklischen Graphen (Abb. 2), berechnet für jede Hardware- und Softwarekomponente

die Effizienzlücke ("efficiency gap") und priorisiert Optimierungspotenziale (Abb. 3). Ein einstellbarer

Präzisionsparameter ermöglicht die flexible Anpassung der Messgenauigkeit und des Overheads.

So werden die wirkungsvollsten Maßnahmen transparent und nachvollziehbar identifiziert.

Gesellschaftliche Herausforderung:

Mit dem Ausbau digitaler Infrastrukturen steigen Energiebedarf und CO2-Emissionen. Die

Erreichung der UN-Nachhaltigkeitsziele, insbesondere bezahlbare und saubere Energie, Industrie

und Innovation sowie Klimaschutz, erfordert neue Lösungen für Energieeffizienz und nachhaltigen

Betrieb. GMB-ECC trägt dazu bei, indem es Energieverbrauch und Optimierungspotenziale

systemweit sichtbar macht und datenbasierte Entscheidungen ermöglicht.

Umsetzung und Impact:

Das Framework wurde für die EU IPCEI-CIS Initiative entwickelt und in einer industriellen

Logistikumgebung mit autonomen Robotern, Edge-Knoten und privatem 5G-Netzwerk getestet. Im

Vergleich zu bisherigen, manuellen Optimierungen wurden folgende Verbesserungen erzielt:

- Energieverbrauch der Edge Nodes um ca. 50%reduziert

- Energiebedarf des Netzwerks um ca. 60% gesenkt

- Gesamtsystem um 12% effizienter

Diese Einsparungen wurden ohne Einbußen bei Servicequalität oder Reaktionszeit erreicht.

Mehrwert und Skalierbarkeit:

GMB-ECC ist generisch und kann auf verschiedenste Edge-Cloud-Umgebungen und Branchen

angewendet werden. Es unterstützt Multi-Tenant- und Multi-Workload-Szenarien und ist offen für

weitere Nachhaltigkeitsmetriken wie CO2 oder Wasserverbrauch. Die Integration in bestehende

Messpraktiken ist möglich und kann schrittweise erfolgen.

Gesellschaftlicher Nutzen:

GMB-ECC schafft erstmals eine transparente, priorisierte und systemweite Steuerung von

Nachhaltigkeit in komplexen IT-Landschaften. Die systematische Messung und das Benchmarking

bilden die Grundlage für nachhaltige, datenbasierte Entscheidungen und ermöglichen die

Überprüfung und Skalierung von Nachhaltigkeitseffekten über den gesamten Stack hinweg. Damit

leistet GMB-ECC einen messbaren Beitrag zur nachhaltigen Digitalisierung und zur Erreichung

globaler Klimaziele.

Fazit:

GMB-ECC macht Nachhaltigkeit systemweit messbar, priorisiert Optimierungspotenziale und

ermöglicht eine effektive, datenbasierte Steuerung nachhaltiger IT-Landschaften.

Gaia Operators

Malik Pätzold, Simon Klüttermann, Tim Katzke, Emmanuel Müller

Verbesserte Generalisierung und effizientere Ressourcennutzung von Neural

Operators, welche Lösungen von Differentialgleichungen (z.B. Navier-Stokes) aus

Daten lernen und massiv weniger Rechenleistung für Simulationen benötigen als

numerische Methoden.

Viele Probleme in Wissenschaft und Technik beinhalten die Lösung komplexer partieller

Differentialgleichungssysteme (PDEs). Beispiele hierfür sind turbulente Strömungen

(Navier-Stokes!) oder Probleme aus der Molekulardynamik, Mikromechanik und Elektrotechnik.

Neural Operator sind eine Verallgemeinerung von neuronalen Netzen, welche Abbildungen

zwischen unendlich dimensionalen Funktionsräumen aus Daten lernen können. Für PDEs wird also

direkt die Abbildung auf die Lösung gelernt. Insbesondere sind Neural Operator für Funktionsräume

designt und daher Invariant bzgl Auflösung. Außerdem sind Neural Operator mehrere

Größenordnungen schneller als numerische Solver, was in der Konsequenz massiv weniger

benötigte Rechenleistung für Simulationen bedeutet.

Das ideale Modell zur Lösung von PDEs erfüllt folgende Anforderungen: (1) jede Auflösung, (2) jede

Frequenz, innerhalb einer festgelegten Fehlertoleranz und bei (3) optimaler Recheneffizienz. Neural

Operator erfüllen durch die Auflösungsinvarianz bereits den wichtigsten ersten Teil dieser

Vorstellung. Allerdings verfügen diese Modelle in der Praxis über Schwachstellen, zu welchen

weitere Forschung notwendig ist. Konkret existiert ein Genauigkeitsverlust bei der Inference auf

gewissen Auflösungsverhältnissen und die Neigung hochfrequente Details zu vernachlässigen.

Letzteres ist bei turbulenten Strömungen, die z.B. bei Navier-Stokes Simulationen auftreten können

(siehe (2)), besonders nachteilig. Darüber hinaus kann für die dritte Eigenschaft das

Pareto-Optimum hinsichtlich Rechenleistung und Vorhersage-Fehler nur durch Quantisierung und

ähnliche Methoden erreicht werden, welche allerdings negative Nebeneffekte haben. Genau diese

Aspekte sollen in dem Projekt weiter erforscht und Lösungen entwickelt werden, daraus entsteht

dann idealerweise eine Bachelorarbeit. Konkret handelt es sich dabei um eine angepasste

Modellarchitektur und modifiziertes Trainingsverfahren. Dieser spezifische Forschungsbereich ist

relativ neu, weshalb erst wenig Literatur existiert und noch vieles unbekannt ist. Gleichzeitig liegt in

dem langfristigen Ziel, ein Modell für PDEs welches die Anforderungen (1)+(2)+(3) realisiert, auch

enormes Potenzial: Neural Operators fanden seit der Veröffentlichung vor ein paar Jahren schnell in

vielen unterschiedlichen Bereichen der (Ingenieur) Wissenschaft Anwendung, essentielle

Forschungsergebnisse wurden tausendfach zitiert. Unter anderem können so Wettervorhersagen

deutlich schneller und günstiger erstellt werden, neue Klima- & Atmospherenmodelle wurden

möglich (SDG 13) und Entwicklungsprozesse sind durch schnellere Simulationen effizienter (SDG

9). Insbesondere kann der Ressourcenverbrauch welcher mit klassischen

High-Performance-Computing assoziiert ist deutlich reduziert werden (SDG 12/13) und - da weniger

leistungsstarke Hardware benötigt wird - demokratisiert sich Zugang zu

Hochleistungs-Simulationen, wodurch Forschung & Entwicklung auch günstiger und weniger

exklusiv wird (SDG 9/17).

ViPER - Visualisierung zur Ausführung von C-Programmen

Niklas Schrötler, Omar Chatila, Konrad Geller, Lennert Hagmann, Steven Hübner, Jannik Malcher, Fabius Mettner, Tobias Mieves, Janina Rau, Niklas Schrötler, Lucas Wilde, Marti Wuttke

ViPER ist eine Web-Anwendung, die Studierenden beim Verständnis von Konzepten wie Zeigern und Speicherallokation helfen soll. Hierzu können sie ohne Setup eigene C++-Programme schreiben und schrittweise ausführen, wobei der Speicher bei jedem Schritt intuitiv erkundbar visuell dargestellt wird.

Das eingereichte Projekt befasst sich mit der Entwicklung eines interaktiven Visualisierungstools für einführende Programmierveranstaltungen wie DAP, mit dem Ziel, Studierenden ein intuitives Verständnis der Ausführung von C++-Programmen im Speicher zu vermitteln. In der Anfangsphase der Programmierausbildung entstehen häufig Missverständnisse über grundlegende Konzepte wie Variablen, Speicherverwaltung oder die Funktionsweise von Datenstrukturen. Studien zeigen, dass Studierende mentale Modelle der Programmausführung, sogenannte Notional Machines, selbst konstruieren, wenn diese nicht explizit vermittelt werden. Fehlende oder fehlerhafte Modelle führen langfristig zu Wissenslücken und erschweren das Erlernen fortgeschrittener Programmierkonzepte.

Unser Tool nutzt eine vereinfachte Version des Word-RAM-Modells, um die Ausführung von Programmen zeilenweise zu visualisieren. Jede Variable wird abstrahiert und in genau einer Speicherzelle dargestellt, unabhängig von Typ oder Größe. Die Visualisierung ist interaktiv und unterstützt etwa durch Pfeil-Darstellungen für Zeiger, wodurch komplexe Strukturen wie Arrays, Structs und natürlich Zeiger selbst anschaulich und verständlich dargestellt werden. Durch die Visualisierung der Speicheränderungen beim Ausführen einzelner Zeilen erkennen Studierende zudem direkt Ursache-Wirkungs-Beziehungen zwischen Code und Speicherzustand.

Neben einer Einbindung in Decker wird die Software für Studierende im Internet bereitgestellt, die eigenständiges Experimentieren ermöglicht ohne hierfür komplexe und plattformabhängige Installation zu erfordern. Dies hilft zusätzlich bei der Integration von Studierenden in Praxisaufgaben, die keinen Laptop besitzen.

Die gesellschaftliche Relevanz des Projekts liegt vor allem in der Förderung von qualitativ hochwertiger Bildung (UN-Nachhaltigkeitsziel 4). Durch die zuvor beschriebenen Vorteile wird die Effizienz des Lernprozesses erhöht, Frustration reduziert und die Chancengleichheit verbessert, da unterschiedliche Lernvoraussetzungen stärker ausgeglichen werden. (UN-Nachhaltigkeitsziel 10)

Die Umsetzbarkeit ist durch die Nutzung bestehender Lehrmaterialien und die Integration in Decker gewährleistet. Erste Implementierungen der Kernfunktionen, wie dem Code-Editor, der Schritt-für-Schritt-Ausführung und der Speichervisualisierung, sind bereits erfolgreich abgeschlossen und eine Fortentwicklung findet im Rahmen der PG 673 statt.